- GPT-Store ist die nächste Plattform von OpenAI.

- GPT-4 Turbo bekommt das bis dato größte Kontextfenster mit 128.000 Tokens.

- Massiv günstigere API-Preise werden den Sektor beflügeln.

Das alles sollte man im Plattformkontext von OpenAI lesen.

Hier kann man die Keynote auf YouTube anschauen. Gehen wir in die Details.

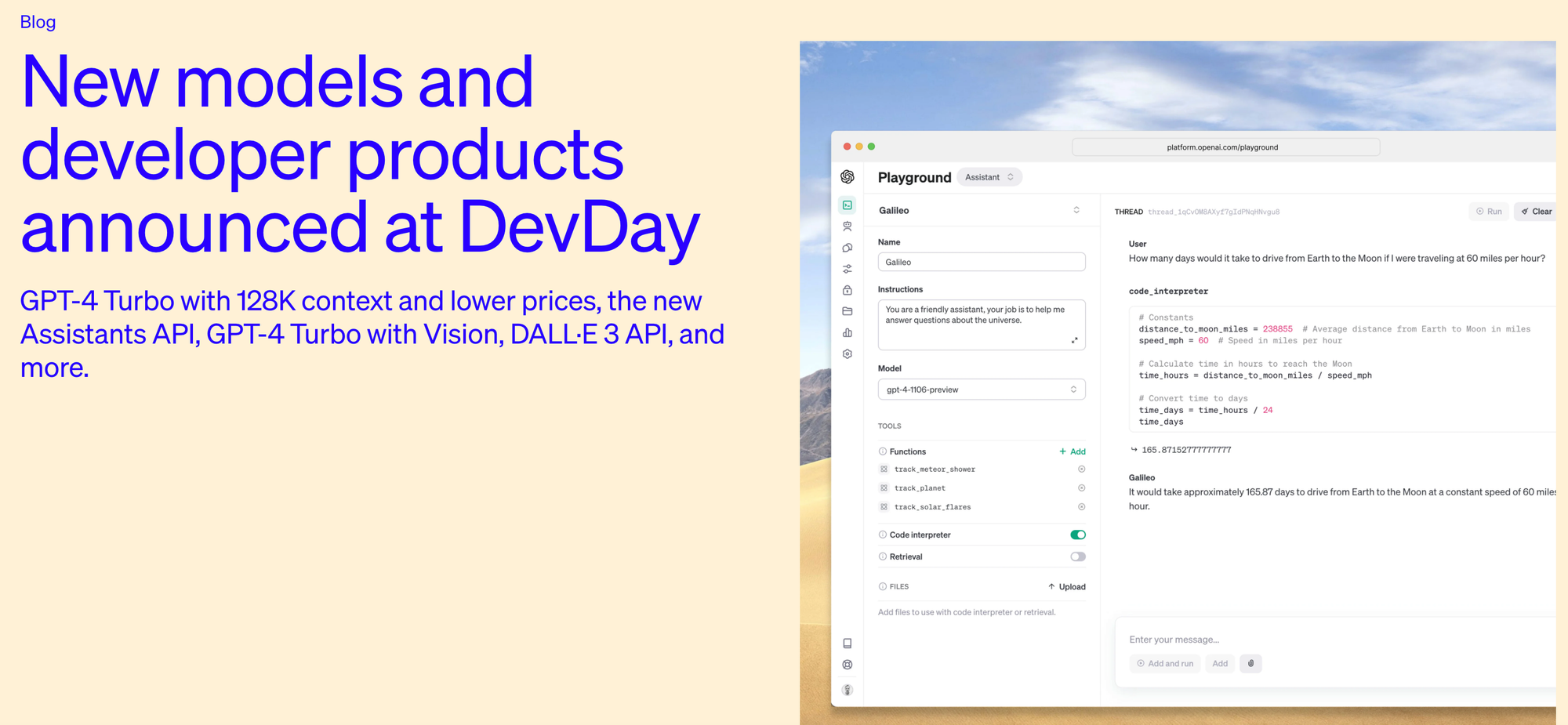

1.: Assistants-API und GPT-Store mit No-Code GPTs

Die neue Assistants-API, die es einfacher macht GPT-basierte Assistenten zu bauen, und der neue GPT-Store gehen Hand in Hand.

This API is designed for flexibility; use cases range from a natural language-based data analysis app, a coding assistant, an AI-powered vacation planner, a voice-controlled DJ, a smart visual canvas--the list goes on. The Assistants API is built on the same capabilities that enable our new GPTs product: custom instructions and tools such as Code interpreter, Retrieval, and function calling.

Entscheidend ist hier, dass OpenAI einen wichtigen Punkt für angepasste, auf OpenAI aufsetzende Dienste architekturseitig übernimmt:

A key change introduced by this API is persistent and infinitely long threads, which allow developers to hand off thread state management to OpenAI and work around context window constraints. With the Assistants API, you simply add each new message to an existing

thread.

Zusätzlich hat OpenAI eine neue Plattform gestartet:

- Leicht mit Prompts erzeugbare spezialisierte (fokussierte?) Versionen von GPT, also mit No-Code erzeugt

- GPTs können privat bleiben oder mit anderen im "GPT Store" geteilt werden

- Mit Umsatzbeteiligung

Das richtet sich an Poweruser wie auch Unternehmen. Im Blogpost erwähnt OpenAI etwa GPTs von Canva und Zapier AI Actions.

Warum das wichtig ist:

- Die Technik allein reicht nicht, klassische plattformseitige Netzwerkeffekte sind ein entscheidender Weg, einen Graben um's eigene (B2C-)Geschäft zu schaffen. Der GPT-Store ist nach den Plugins der zweite Wurf in diese Richtung für OpenAI.

- LLMs sind leere Leinwände. Man kann alles mit ihnen machen, aber was kann man mit ihnen machen? Leute brauchen einen Anhaltspunkt, einen Startpunkt. Es ist noch unklar, an welchen Stellen LLMs Angebote ermöglichen werden, die alles unter einem Dach haben werden und wo und wie sie sehr spezifisch werden.

GPTs erinnern uns natürlich an Quoras Poe (siehe meine Analyse).

Der große Unterschied zwischen Poe und OpenAIs GPTs liegt in der vertikalen Integrationsstufe. Dank des Microsoft-Deals (alles, was OpenAI baut, muss als Azure-API verfügbar werden), bin ich gespannt, welche First-Party-Vorteile GPTs erhalten werden/können.

Außerdem: Noch eine Stufe weiter in die andere Richtung gehen die neuen Modell-Anpassungen. OpenAI hat u.a. ein neues Custom Models program, ein "very limited (and expensive) program". Sprich ein Enterprise-Angebot, das sich vornehmlich an Konzerne und Regierungen richtet.

2.: 128.000 Tokens bei GPT-4 Turbo

Die neuen Modelle, via heise:

Die generativen Sprachmodelle GPT 3.5 und GPT 4 erhalten jeweils eine "Turbo" genannte Version, die mehr kann und billiger zu nutzen ist. Ist das bisherige GPT 4 mit Informationen mit Stand September 2021 trainiert, wurde GPT 4 Turbo Daten bis April 2023 gefüttert. Bei der Beantwortung von Befehlen (prompts) kann GPT 4 Turbo Context mit bis zu 131,072 Token (128K) auswerten (statt 8,096 bei GPT 4 8K respektive 32,768 bei GPT 4 32K).

Der wichtigste Punkt ist die größere Token-Zahl bei GPT-4 Turbo.

Tokens können sein: Teile von Wörtern, Wörter oder Teile von Sätzen. Tokens sind die Bausteine der Sprachmodelle, Sinneinheiten, vielleicht vergleichbar mit Noten in der Musik.

~ 📧 Jetzt abonnieren und künftig die öffentlichen Analysen von neunetz.com kostenfrei und bequem einmal pro Woche per Email erhalten! ~

Kontext:

- Anthropics Claude 2 kann 100.000 Tokens verarbeiten und war damit bis dato das B2C-LLM mit dem größten Kontextfenster.

- Größere Kontextfenster erlauben einen umfangreicheren Input.

Warum das wichtig ist:

- Das oft gemachte Beispiel ist: "Jetzt kann ich dem Modell ein Dokument (Buch, etc.) als Input geben und damit arbeiten."

- Sinnvoller ist es aber, auf der Projekt-Ebene zu denken: Mit größeren Kontextfenstern können mehr Input-Abfragen (Prompts) hintereinander kommen. Das Modell "vergisst" nicht die vorherigen Eingaben.

Man kann es auch so sagen: Claude 2 und GPT-4 Turbo haben ein ausreichend großes Gedächtnis, um mit ihnen in einen "Dialog"1 einzusteigen. Alle anderen Modelle leiden unter "Demenz".

Größere Kontextfenster erhöhen die Zahl der möglichen Einsatzarten enorm.

3.: Günstigere API-Preise

GPT-4 Turbo und GPT-3.5 16K arbeiten jetzt effizienter, was zu niedrigeren API-Preisen führt. heise:

GPT 4 Turbo verrechnet pro 1.000 Eingabetoken von drei US-Cent (GPT 4 8K) respektive sechs Cent (GPT 4 32K) auf nur noch einen Cent. Bei der Ausgabe fällt der Preis von sechs respektive zwölf Cent auf drei Cent.

Das sind enorme Preissenkungen.

Warum das wichtig ist:

- Was Azure hat bekommen die OpenAI-APIs und umgekehrt. Für Microsoft Azure sind niedrigere Preise gleichbedeutend mit Ausbau des Marktanteils.

- Im B2C-Bereich bedeutet das, dass wir künftig KI-Dienste sehen werden, die auf OpenAI bauend günstiger sein werden.

- Niedrigere Preise sind nur mit niedrigeren Kosten möglich. Niedrigere Kosten sind hier gleichbedeutend mit niedrigerem Energieverbrauch.

Fazit

Es gab noch weitere Neuerungen, aber das sind die entscheidenden Aspekte.

Kurz erwähnen sollte man noch den Copyright-Schutz und die Multimodalität der neuen Modellrichtungen bei OpenAI (Sprache, Dall-E-3-Integration).

Macht man einen Schritt zurück, ergibt sich ein wenig überraschendes, weil in sich schlüssiges Bild:

**Die dieswöchigen Neuerungen stellen naheliegende Verbesserungen dar. Mit der Richtung, die sie uns zeigen, können wir nicht nur jetzt, sondern auch die nächsten Jahre rechnen. **Natürlich werden LLMs günstiger weil effizienter werden. Natürlich werden sie effektiver in der Verarbeitung der Inputs. Und natürlich wird Multimodalität eine zunehmend große Rolle spielen.

Und natürlich wird jeder große Player in dem Feld versuchen, (mindestens) eine erfolgreiche Plattform aufzubauen.

- Die Wörter, die wir für diese Dinge benutzen, sind alle in ihrer Anthropomorphisierung schwierig, aber Mangels besserer Begriffe verwende ich das, was alle verstehen, und damit es Korinthenkackern nicht langweilig wird. ↩