Hi,

man merkt an turbulenten Zeiten, dass es kein Sommerloch bei den Themen gibt.

Nach der Sommerpause gibt es einige Themen aufzuarbeiten. Heute gibt es deshalb unter anderem noch ein paar Anmerkungen zu GPT-5.

Noch ein Hinweis in eigener Sache: Das Briefing wird künftig wie heute Montags erscheinen und nicht mehr Freitags. Weitere Neuerungen dann in naher Zukunft.

Marcel

Im Fokus dieser Ausgabe:

- Die Kosten und das User-Interface von GPT-5 werfen Fragen zur Differenzierung von KI-Produkten auf.

- Auch: GPT-5 im Pro-Modus ist mächtig. Und: Preisgestaltung und das Interface von GPT-5 sind für professionelle Nutzer:innen weiterhin problematisch.

- KI in der Bildung: Eindeutig sinnvoll.

- Sicherheitslücken bei KI-Browsern wie Comet zeigen neue Risiken für Nutzer:innen und ihre Daten.

- Die Übernahme von Media Saturn durch JD könnte den Anfang einer neuen Ära bedeuten für den deutschen Handel. Vor allem, weil in China Geld vorhanden ist, das ohne Probleme große deutsche Unternehmen aufkaufen kann.

- Agentic Commerce verändert die Rolle von Daten und Marktplätzen im Onlinehandel grundlegend.

- DeepSeek und chinesische Chips.

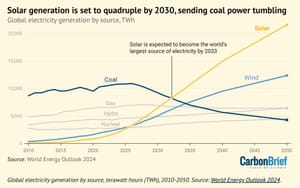

- Solar wird sich global mindestens vervierfachen bis 2030.

- und mehr

Zitat des Tages

At some point the meaning of ‘driving’ and ‘self-driving’ will invert.

At some point the meaning of ‘driving’ and ‘self-driving’ will invert.

— ZΞfi (@zefi) August 5, 2025

🤖 KI

GPT-5, Kosten und Router

So viel Gegenwind, dass es ein Abendessen mit Journalist:innen in San Francisco gab, bei dem Altman und weitere Executives von OpenAI on the record(!) Fragen beantworteten. Eine Folge, wenn nicht nur das eigene Produkt zu den erfolgreichsten der Menschheitsgeschichte gehört, sondern das eigene Marketing noch einen draufsetzt (AGI?).

Sam Altman hat in Interviews mit The Verge und Axios ungewöhnlich offen Fehler beim Launch von GPT-5 eingeräumt: OpenAI habe „einige Dinge total vermasselt“, insbesondere beim Wechsel des Standardmodells und der Kommunikation mit den Nutzer:innen. Während der Launch für Endkund:innen eher durchwachsen verlief, verdoppelte sich wohl das API-Volumen in kurzer Zeit. OpenAI stößt inzwischen an die Grenzen der verfügbaren GPUs. Altman betonte, dass er aus dem Rollout gelernt habe, was es bedeutet, ein Produkt für Hunderte Millionen Menschen über Nacht zu ändern. (The Verge)

Ich schätze, dazu zählen bahnbrechende Erkenntnisse wie, dass man zahlenden Kund:innen nicht ohne Ankündigung Features wegnimmt.

Etwas, das in meinen Augen offensichtlich ist, ich aber erstaunlicherweise bisher nirgendwo gelesen habe:

Es ergibt keinen Sinn, dass ein Produkt, das 200$ pro Monat kostet, das exakt gleiche User-Interface hat wie ein kostenfreier (bald werbefinanzierter) Mainstream-Service.

Dass OpenAI an einem Dropdown-Menü scheitert und davon ausgeht, dass sich KI-Produkte über alle Preissegmente hinweg vor allem nur in Nutzungsgrenzen und im Zugang zu besseren Modellen unterscheiden, ist wirklich bemerkenswert.

Product people, where art thou.

Der Router

Das Wichtigste an GPT-5 ist der Router, das eigentliche Produkt, das hier eingeführt wurde. Ein vorgelagertes Modell, das die Anfrage analysiert und dann zum schnellen, kostengünstigeren, leichteren Modell oder zum Thinking-Modell leitet. Anstatt kryptischer Modellnamen.

Das ist einerseits die richtige Entwicklung, andererseits problematisch:

- Die Blackbox LLM wird im B2C-Bereich damit noch blackboxiger. Weil eine vorherige Auswahlmöglichkeit durch einen weiteren Automatismus ersetzt wird.

- E gibt hier einen Interessenskonflikt: OpenAI steuert mit dem Router, welche Kosten ihnen eine Anfrage verursacht. Geringere Kosten = geringere Qualität des Outputs. OpenAI kann ohne, dass die User das nachvollziehen können, die Hebel im Hintergrund Richtung Qualität oder Kosten umlegen.

- Beides, Black Box und Interessenskonflikt, kamen direkt im Launch von GPT-5 zusammen: Augenscheinlich war der Router zu sehr auf Kostenersparnis/Geschwindigkeit geeicht. Das machte GPT-5 für viele User "dümmer". Das Unternehmen behauptete dann, dass es sich um einen Fehler gehandelt habe. Ob das stimmt, wissen wir nicht.

Die Spannung zwischen Komplexität der Technologie und Zugänglichkeit des Interfaces ist ein permanenter Balanceakt; der bei LLMs noch diffiziler geworden ist.

These: LLM-Produkte werden heute immer noch gebaut wie klassische Software, brauchen aber ein grundlegend neues UX-Paradigma. Weil LLMs viel komplexer und idiosynkratischer sind als jeder andere Software-Baustein.

Die Kosten

ChatGPT hat über 700 Millionen wöchentlich aktive Nutzer:innen. (Monatlich aktive Nutzer:innen dürften bei über einer Milliarde liegen.)

Neben leistungsfähigeren Modellen hat hier vor allem der Kostenfaktor eine hohe Priorität für das Unternehmen.

Anthropics Modelle sind oft gleichauf mit OpenAI, oder besser, aber nahezu immer teurer weil rechenintensiver (lies: weniger effizient). Das macht sich in Nutzungslimits bei Claude selbst oder bei Claude in Cursor bemerkbar. OpenAI kann sich das bei seiner Nutzerzahl, B2C wie B2B, schlicht nicht leisten. Wortwörtlich.

GPT-5 Standard ist ungefähr halb so teuer wie GPT-4o. (Das für ChatGPT nicht relevante Modell GPT-5 nano ist bis zu 90% günstiger.)

Der große Endgegner für OpenAI neben den offenen Modellen aus China ist Google. GPT-5 liegt preislich ungefähr auf Niveau von Googles Gemini 2.5 Pro (Basis). Google profitiert hier von seinem vertikal integrierten Techstack bis hin zu den eigenen KI-Chips.

Das Wachstum der Google Cloud Platform, Googles Cloud-Angebot, profitiert enorm von den günstigen, leistungsfähigen Gemini-Modellen und kann aktuell nur so schnell wachsen wie sie die Datencenter ausbauen können.

Mehr Nachfrage als Angebot. It's a theme.

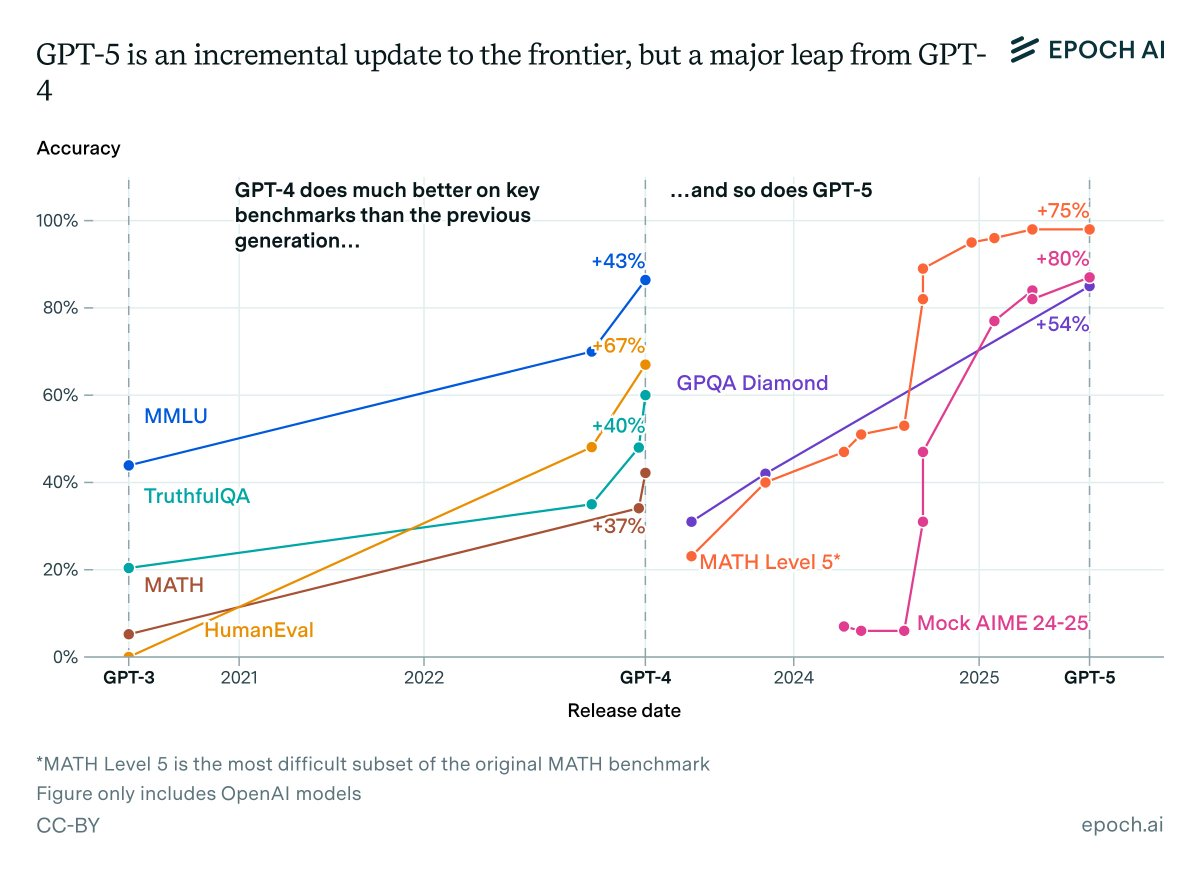

GPT-5-Qualität

Zunächst: GPT-5 ist ein Opfer des überbordenden Marketings der KI-Startups. Viele haben erwartet, dass OpenAI beim "Versionssprung" von 4 auf 5 etwas ähnliches liefert wie von 3 auf 4. Das war aus einem einfachen Grund unmöglich:

Wettbewerb.

OpenAI, Anthropic, Google und die chinesischen Labs (und mit Abstrichen Mistral) liefern sich ein konstantes Kopf-an-Kopf-Rennen, wer aggressiven Sichern von Marktanteilen mit dem qualitativ besten (und bezahlbaren!) Modell am Markt vorn liegt. Herrscht bei einem Lab für mehr als vier Monate Stille, gehen die Gerüchte los. KI ist immer noch ein (gemessen am Potenzial) vergleichsweise kleiner, aber sehr rasant wachsender Markt. Das erzeugt Druck:

- Sowohl beim Launch von GPT-5 als auch bei Claude im Coding-Sektor: Modelle entwickeln langsam Stickyness bei Powerusern, entweder emtionaler Art wie bei 4o (hochproblematisch), oder auf andere sanfte, nicht quantifizierbare Arten wie Claude im Programmierbereich. (Marktanteile von Claude schwanken

- Talent spielt (mehr oder weniger aradoxerweise) immer noch eine große Rolle im KI-Sektor. Labs, die wahrgenommen werden als nicht an der Speerspitze zu stehen, können Leute schneller verlieren oder, schwerwiegender, nicht neue Toptalente anziehen. (U.a. Metas Problem vor dem Reorg.) Die Nachfrage ist größer als das Angebot. Nicht nur bei der KI-Nutzung, sondern auch bei den KI-Forschenden.

- Die Früchte bei der Technologieentwicklung hängen noch immer tief genug, so dass kein KI-Lab lang an der Spitze der Benchmarks bleibt. Alle werden konstant inkrementell besser.

-> Aus all dem folgt, dass kein Anbieter es sich leisten kann, mehr als eine Generation neuer Modelle zurückzuhalten, nur damit der Marketingsplash größer ist. In Sam Altmans Traumwelt hätten sie auf alle Reasoningmodelle verzichten können und nach einem dreiviertel Jahr Ruhe mit GPT-5 um die Ecke kommen können. BUT ALAS.

Der Unterschied zwischen der ersten Version von GPT-4 und dem heutigen GPT-5-System ist riesig. Und zwischen beiden liegen lediglich zwei Jahre.

(Im Grunde war das erste Reasoning-Modell von OpenAI der eigentliche Nachfolger von GPT-4, also GPT-5 im Geiste.)

Epoch AI hat das anhand des Math-Benchmarks grafisch aufbereitet:

Aber das ist alles nicht wirklich entscheidend. Relevanter ist die Frage, ob mit GPT-5 neue Dinge möglich sind.

GPT-5 ist, zumindest im teuersten Pro-Modus, sehr mächtig. Erste Top-Forscher:innen sind richtig aus dem Häuschen.

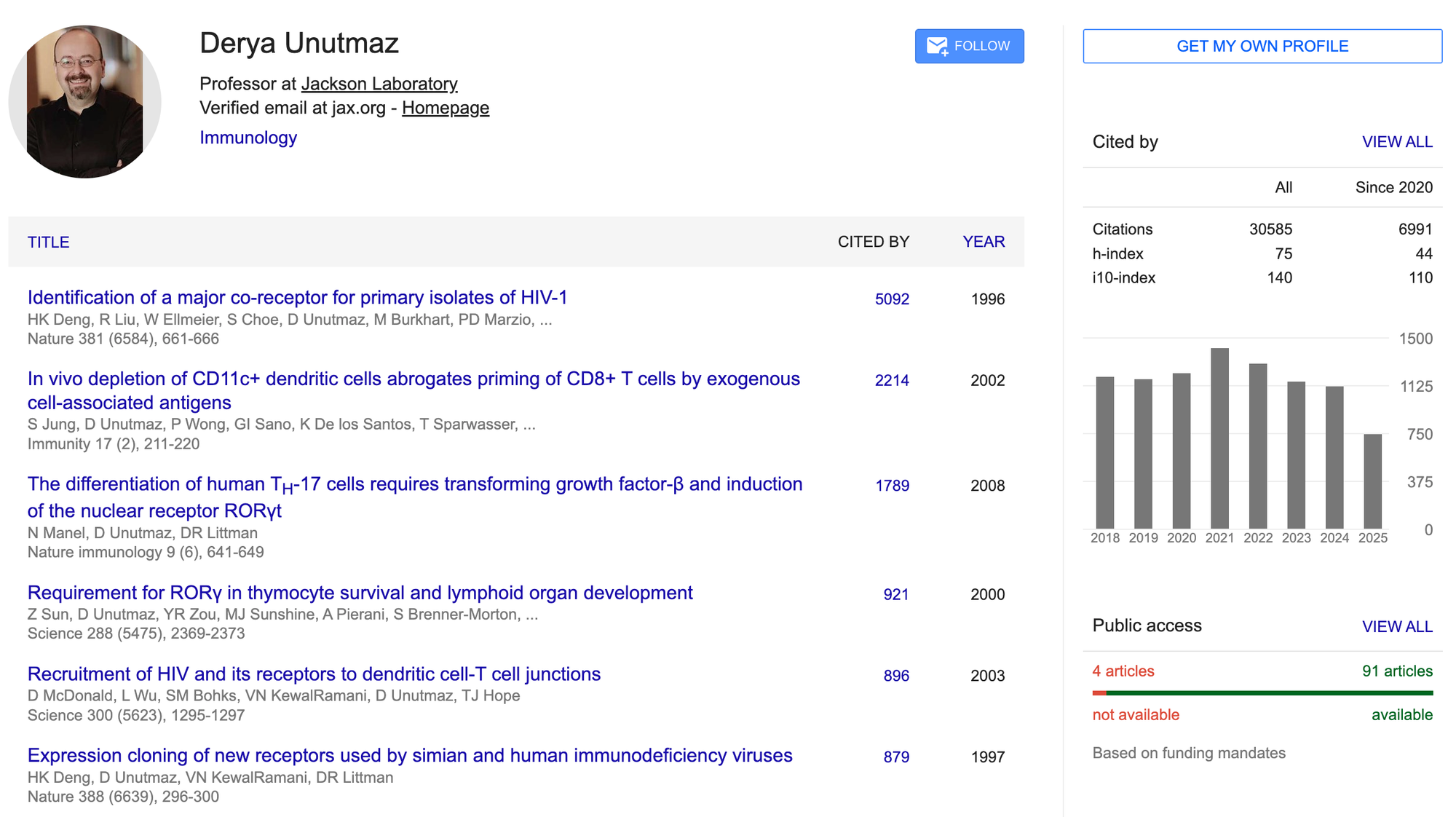

Als Beispiel schauen wir auf die Aussagen von Dr. Derya Unutmaz. Unutmaz ist einer der führenden Immunologen weltweit. Für den Kontext hier sein Scholar-Profil:

Unutmaz hat GPT-5 anhand unveröffentlichter Studiendaten getestet. Das Modell hat die gleichen Ergebnisse aus den Daten produziert wie das hochkomplexe Experiment:

In a social media post, Unutmaz revealed that he used GPT-5 to predict the results of a month-long, highly complex experiment aimed at engineering cells to fight lymphoma. The AI’s predictions, he said, were “astonishingly accurate”. [...]

Unutmaz noted that GPT-5 not only forecasted the entire experimental process and results with high precision, but also suggested design improvements.

Er schreibt auf X auch:

At this point, I may have to revise my timeline for curing aging to a date earlier than the 2040s!

Doubt no more. Thanks to AI, we will treat all diseases and reverse aging!

Unutmaz wurde nach diesen Aussagen von OpenAI direkt für ein Werbevideo eingesetzt.

Ebenfalls ein gutes anschauliches Beispiel für die Planungsfähigkeiten von GPT-5 hat Ethan Mollick hier aufgeschrieben:

If you didn’t catch the many tricks - the first word of each sentence spells out the phrase This is a Big Deal, each sentence is precisely one word longer than the previous sentence. each word in a sentence mostly starts with the same letter, and it is coherent writing with an interesting sense of style. In a paragraph, GPT-5 shows it can come up with a clever idea, plan, and manage the complicated execution (remember when AI couldn’t count the number of Rs in “strawberry”? that was eight months ago).

Descript Underlord: KI-Videoeditor

Descript baut mit dem amüsant benannten "Underlord" einen KI-Videoeditor.

Möglich ist das, weil Descript bereits bekanntlich textbasierte Bearbeitung von Audio- und Videoinhalten anbietet. Das LLM-Feature kann über diesen bestehenden Weg auch direkt die Inhalte ändern.

Besser integrierte LLMs, wenn die notwendige Basis dafür bereits gelegt wurde. This is the way.

KI in der Bildung

Sascha Lobo schreibt auf Spiegel über KI an Schulen.

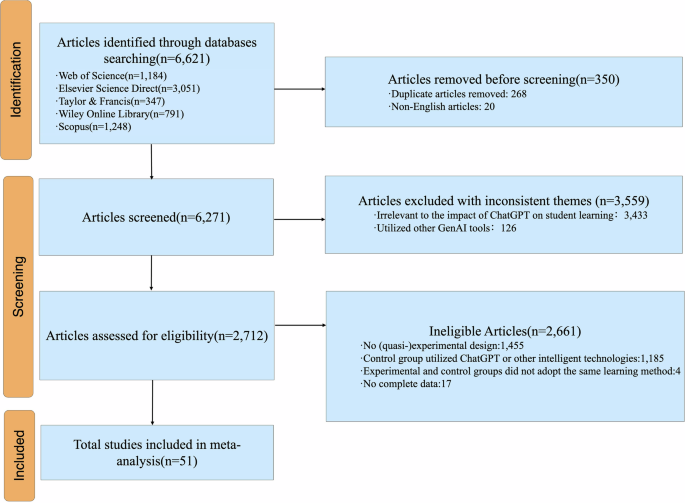

Wir hatten eine der wichtigen Metastudien zu KI in der Bildung hier bereits im Briefing. Es lohnt sich aber, auf die Forschungsergebnisse zu KI in Bildung noch einmal hinzuweisen, weil es so wichtig ist.

Metastudien finden eindeutige positive Effekte bei richtigem Einsatz:

Die Technologie kann natürlich falsch oder richtig implementiert werden. Auf die Frage, ob KI sinnvoll im Bildungswesen eingesetzt werden kann, antwortet die Forschung eindeutig: Ja.

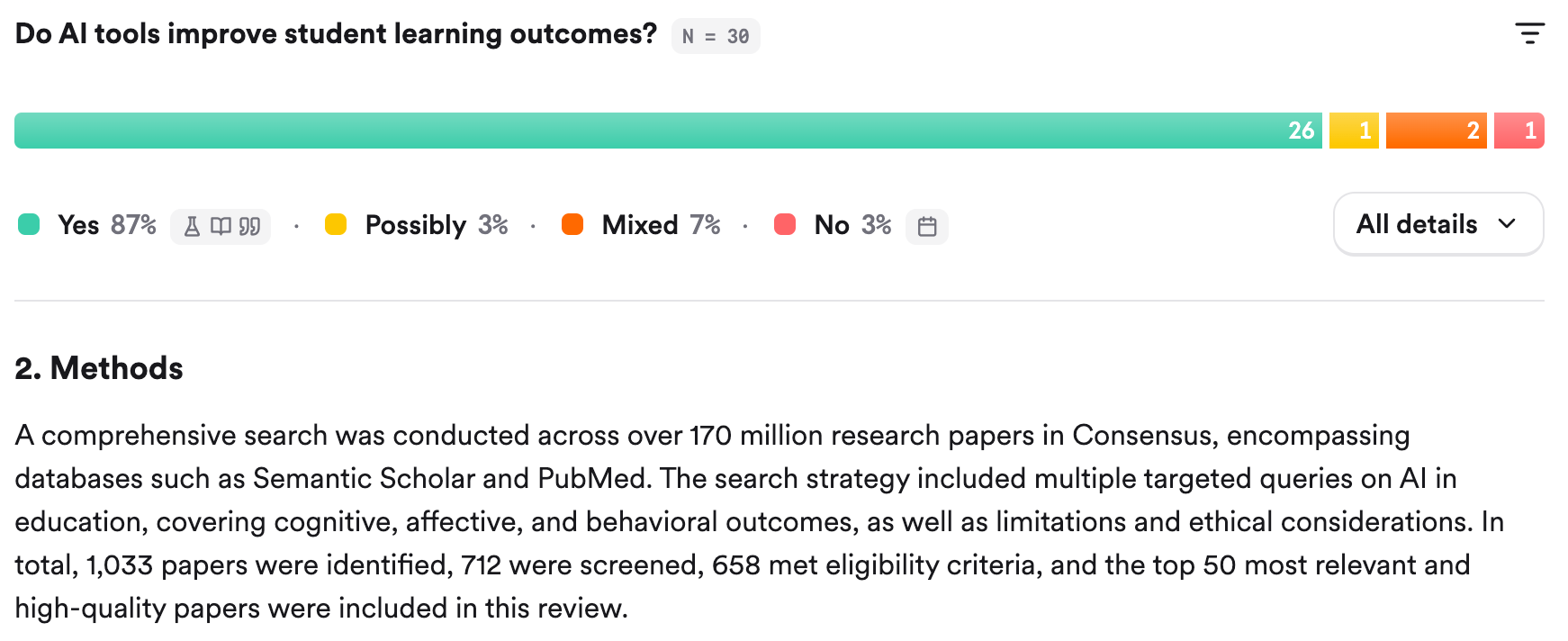

Ich nutze für Recherchen von akademischen Papern ab und an Consensus. Das aggregierte Ergebnis dieses Recherchewerkzeugs ist, zusätzlich zu ebenfalls eindeutig:

Saschas Kolumne zur KI-Pflicht ist also weniger kontrovers als ein No-Brainer. Zumindest, wenn man sich an der Forschung zum Thema orientiert.

Und last not least besonders wenn man bedenkt, wie KI in Rekordzeit unseren Alltag durchdringt. Augen zuhalten und Erlkönig auswendig lernen allein wird nicht reichen.

Es gibt nur 7 KI-Apps

Lesen Sie die ganze Geschichte

Melden Sie sich jetzt an, um die vollständige Geschichte zu lesen und Zugriff auf alle Beiträge nur für Mitglieder zu erhalten.

Abonnieren