Ich war vor ein paar Tagen bei den TikTok Awards. Das Erstaunlichste für mich war, wie überaus politisch alle auf der Bühne waren. Natürlich sind die meisten auf TikTok erfolgreichen Accounts auf Entertainment beschränkt. Aber es war interessant zu sehen, dass nicht nur allen bewusst war, welche gesellschaftliche Verantwortung mit enormer Reichweite einher geht, sondern dass sie sich das auch kollektiv gegenseitig vergewissert haben. Ein einhelliger Konsens in einem Raum mit den reichweitenstärksten Influencern des deutschsprachigen Raums.

Was ich damit sagen will: The kids are alright.

Aufgrund verschiedener Umstände, zu denen ein kleiner Burnout gehört, hatte sich eine ungeplante Briefingpause eingeschlichen. Ich habe in dieser Zeit unter anderem einen Text über Europas fragile Position angefangen, dessen Länge den Rahmen eines Briefings mittlerweile sprengen würde. Das erscheint zu einem anderen Zeitpunkt. Europas Position und die realistischen Optionen, die uns noch offen stehen, gehören zu meinen Kernthemen auf absehbare Zeit (bis Lebensende). Es ist sehr wichtig, hier pragmatisch und konstruktiv in die Zukunft zu schauen. Einen guten Teil meiner Gedanken dazu bekommt man im Tech&Tales-Podcast zu hören, wo ich in zwei Ausgaben zu Gast bin. Siehe dazu auch unten. Weitere Gedanken dazu auch heute im Briefing.

Marcel

In diesem Briefing:

- Googles vertikaler Stack: TPUs machen Gemini 3 stark, senken Inferenzkosten und setzen AWS, Nvidia und andere Player unter Druck.

- „Code Red“ bei OpenAI: Gemini 3 zieht ein Kopf-an-Kopf-Rennen mit Claude 4.5 und GPT‑5.2 nach sich. Für Nutzer gut, auch für Europa.

- „Souveränität“: Deutschland/EU haben Investitionsfenster verpasst; strategische Unabhängigkeit bleibt auf Jahre fraglich.

- Chinesische Modelle in US-Startups: DeepSeek/Qwen/GLM werden zur Infrastruktur - gut genug, günstig und schnell verfügbar.

- Kimi K2 Thinking: Ein offenes MoE‑Reasoning‑Modell mit interleaved thinking als leistungsfähiger Baustein für komplexe Agenten.

- Implikationen offener Modelle: Parität mit proprietären SOTA rückt näher; Inferenz-Infrastruktur wird zum europäischen Hebel.

- Regulierung/iRobot: EU blockte Amazons Rettung, iRobot fällt an China, Kartellrecht verfehlte den globalen Kontext.

- Medienwandel/Netflix–Warner: Netflix bündelt Blockbuster und HBO‑Bibliothek, beschleunigt die Streaming‑Konsolidierung.

- All about Time: YouTube gewinnt TV‑Zeit und dominiert Aufmerksamkeit. Ohne nationalen Schulterschluss sterben lokale Streaming‑Versuche.

- und mehr

Zitat des Tages

Thought experiment for AI is autocomplete skeptics

What’s the difference between “knowing something” vs accurately predicting what’s next?

Nick Dobos auf X

In den Podcasts

Mit Sascha Lobo und Elisabeth L’Orange habe ich in Folge 34 von Tech, KI & Schmetterlinge über Messenger, der vielleicht wichtigsten, weil omnipräsenten digitalen Austauschform, gesprochen.

Außerdem war ich bei Elisabeths Tech & Tale Podcast zu Gast. Elisabeth wollte mit mir über Dystopien sprechen. Nicht unbedingt meine thematische Lieblingsrichtung. Weil ich der Ansicht bin, dass einerseits bei dystopischen Szenarien fast immer die gesellschaftlichen Abwehrkräfte ausgeblendet werden (obwohl gerade bei jeder Antizipation einer Verschlechterung -und Szenarien sind Antizipationen- gerade der Fokus auf gegenwirkende Kräfte wichtig ist).

Und andererseits, weil hierzulande ein viel zu starker Fokus auf Risiken und Gefahren gelegt wird, hochgejazzt zu dystopischen, lähmenden Erzählungen, ohne über die konstruktiven Potenziale ausreichend zu sprechen. Nicht dass es unwichtig ist, über negative Folgen und Nachteile zu sprechen, aber es herrscht in Europa ein starkes Ungleichgewicht zugunsten der (oft sogar nur eingebildeten) Risiken.

Umso spannender fand ich die Diskussion mit Elisabeth, die in 2 Folgen im Podcast erschienen. Der zweite Teil sollte am Wochenende im Podcastclient Ihres Vertrauens gelandet sein. Darin sprechen wir über das meiner Ansicht nach beunruhigendste, weil gleichzeitig realistischste dystopische Szenario: Was wenn KI eine sehr gute, nützliche, disruptive neue Technologie ist und Europa darin einfach keine global relevante Rolle spielt? Was passiert dann mit Europa und der europäischen Wirtschaft? Spooky stuff.

Mit Jochen Krisch habe ich in den Exchanges ausführlich über KI im Onlinehandel gesprochen.

Exchanges #386: Die E-Commerce-Strategien von OpenAI & Co.:

OpenAI baut mit den eigenen „Apps“, Instant Checkout und Shopping Research mit eigenem KI-Modell massiv den Commerce-Aspekt aus. Und auch Perplexity legt mit Instant Buy und Virtual Try-On nach. Es bleibt nur eine Frage der Zeit, bis auch Google seine KI auf seine Shoppingsuche loslässt. In den neuesten Exchanges schauen sich Jochen Krisch und Marcel Weiß die unterschiedlichen Shopping-Ansätze der KI-First-Player genauer an.

Exchanges #385: Agentic Shopping im KI-Browser

Was bringen Shopping-Agenten im E-Commerce? In den neuesten Exchanges unterhalten sich Jochen Krisch und Marcel Weiß über die Agentic Shopping Möglichkeiten in den neuen KI-Browsern und warum (nicht nur) Amazon ein Problem damit hat.

Thema der Woche: US-Modelle, China-Modelle und globale AI-Infrastruktur

Honestly, modern Europeans should look over at China, and then look at how they've turned against technology, and they should be ashamed of themselves.

Googles vertikaler Stack: TPUs, Scaling Laws, und Gemini 3

Bei Google sieht man die Vorteile des eigenen vertikalen Stacks. Das sehr gute neue Gemini 3 ist auf Googles eigenen TPUs trainiert. Googles TPUs sind ein enormer Vorteil: Sie machen Google zum Hauptkonkurrenten für US-Modelprovider OpenAI und Anthropic und gleichzeitig zum größten Herausforderer von Nvidia. But wait there is more: TPUs über die Google Cloud Platform könnten langfristig auch eine Herausforderung für Azure und, mehr noch, AWS werden, weil beide auf Performancesprünge bei Nvidia angewiesen sind.

AWS’ eigene Trainium-Chips haben sich als gut für Inferenz, aber, nomen nicht omen, nicht gut für Training von Modellen herausgestellt. Am besten sieht man das bei Anthropic. Anthropic hat jüngst einen großen Deal mit Google abgeschlossen. Bis dato war Anthropic das eine Vorzeigebeispiel für AWS, weil sie Claude auf Trainium trainiert haben. (Was sicher ein für Anthropic schmerzhafter Bestandteil der Amazon-Investitionen in das Startup war.)

Nun also der Google-Deal: Anthropic sagen, dass die zusätzlichen Google-Cloud-TPUs vor allem die massiv wachsende Nachfrage der über 300.000 Geschäftskunden bedienen sollen und zugleich „more thorough testing, alignment research, and responsible deployment at scale“ ermöglichen. Kurz: mehr Rechenleistung für die Weiterentwicklung der Modelle, umfangreichere Sicherheitstests und den zuverlässigen, großflächigen Betrieb.

Anthropic bleibt AWS treu, aber das scheint eher aus Mangel an Alternativen und aus Existenz bestehender Verträge heraus der Fall zu sein:

We remain committed to our partnership with Amazon, our primary training partner and cloud provider, and continue to work with the company on Project Rainier, a massive compute cluster with hundreds of thousands of AI chips across multiple U.S. data centers.

Last not least, auch OpenAI hat begonnen, TPUs über Google Cloud anzumieten, um die Kosten für Inferenzberechnungen zu senken und die wachsenden Rechenanforderungen zu decken. Reuters:

OpenAI hopes the TPUs, which it rents through Google Cloud, will help lower the cost of inference, according to the report.

Besonders der Kostensenkungsaspekt sollte auf etwas hindeuten, das vielen in der Branche bereits bekannt ist: Googles TPUs erlauben sehr kostengünstige KI-Bereitstellung.

However, Google, an OpenAI competitor in the AI race, is not renting its most powerful TPUs to its rival, The Information said, citing a Google Cloud employee.

Im Juli 2024 hat Google einen Rückblick auf ihre Chip- & Infrastruktur-Arbeit veröffentlicht:

TPU transformation: A look back at 10 years of our AI-specialized chips | Google Cloud Blog

Die massive TPU-Infrastruktur bei Google war einer der Gründe, warum Gemini 3 so gut ist. Gemini 3 dürfte das größte Modell aktuell sein. Es ist auf jeden Fall das Modell, das mit der größten Rechenleistung trainiert wurde.

Das ist ein wichtiger Punkt: Die Scaling Laws für Pretraining sind intakt. Sprich: Mehr Rechenleistung führt noch immer zu besseren Modellen.

Und: Es dürfte noch kein veröffentlichtes Modell geben, das auf Nvidias neuen Blackwell-Chips trainiert wurde.

Nehmen wir weitere Entwicklungen zu diesem Umstand hinzu, wie etwa der Forschungsfokus auf bessere Reward-Funktionen für Reinforcement Learning (RL) ohne menschliches Feedback (das weniger schnell skaliert als automatisiertes RL und eine geringere Verteilung aufweisen kann (man denke an AlphaGo Zero)).

Dann lässt sich unterm Strich in Summe festhalten: Ein Ende der rasanten Weiterentwicklung der Technologie ist weiterhin nicht in Sicht.

„Code Red“ bei OpenAI; wünschenswerte und weniger wünschenswerte Szenarien für Europa

Gemini 3 hat bei OpenAI „Code Red“ (in einem internen Memo) ausgelöst und zum vielleicht vorgezogenen Release von GPT 5.2 geführt. (u.a. Venturebeat)

Einerseits ist es interessant, wie gut Gemini 3 ist. Aber viel interessanter ist, dass innerhalb von Tagen Claude 4.5 Opus erschien, das bereits Gemini 3 in einigen Benchmarks schlug und ein paar Tage später GPT 5.2 von OpenAI nochmal auf der Messlatte zulegt.

Als bekannt wurde, dass bei OpenAI intern Panik ausbrach wegen Gemini 3 (und wahrscheinlich bei internen Frühwarn-Kennzahlen), war die Häme auf LinkedIn groß.

Das ist einerseits verständlich, wenn man die als warnendes Understatement versteckte Megalomanie von OpenAI-CEO Sam Altman bedenkt, aber andererseits, ach andererseits:

Europa ist, wenn man Ausnahmen wie Mistral oder Pleias aus Frankreich oder Black Forest Labs aus Deutschland beiseite lässt, in erster Linie Konsument von KI. (Eine gute Aussicht auf infrastrukturelle Relevanz sehe ich aktuell nur bei Mistral. Das ist zu wenig für die gesamte EU.) Global Schlagzeilen machende KI-Modelle und Produkte kommen entweder aus den USA oder aus China. Europa hat bereits die Internetwelle von 2005 bis 2020 verschlafen und schaut nun zu, wie die in dieser Zeit entstandenen Tech-Riesen aus den USA lange Zeit einfach aus dem eigenen, hochprofitablen Cashflow heraus eine Capex-Explosion finanziert haben, die Kapazitäten ausbaut, welche sehr nah an ihrem Kerngeschäft sind. Und hierzulande sahen alle mit großen Augen sofort eine Blase.

Das verlangt einen eigenen Essay, deshalb nur kurz: Wir sind mitten in einem technologischen Boom. Natürlich geht eine Boomphase zwangsläufig mit einer Spekulationsblase einher, das liegt in der Natur der Sache, weil niemand in die Zukunft schauen kann. Wer in einer solchen Situation nur über eine mögliche Spekulationsblase spricht, ohne den sie auslösenden Boom zu thematisieren, sieht den Wald vor lauter Bäumen nicht.

Wenn wir als Wirtschaftsstandort bestenfalls passive Nutznießer einer neuen technologischen Wertschöpfungssituation sind, und danach sieht es aktuell aus, dann können wir uns mindestens kollektiv im nächsten Schritt fragen, was das bestmögliche Szenario ist, wenn unsere Bestreben nach „digitaler Souveränität“ nicht vollumfänglich erfolgreich sein werden:

- Sam Altman und OpenAI werden tatsächlich so groß und erfolgreich, wie behauptet.

- Google haut Sam auf den Kopf, hurra, Google gewinnt.

Die Antwort ist nicht hypothetisch, sondern bereits mit heutigen Vorgängen eindeutig:

Verlage können derzeit nicht im Google-Suchindex vorhanden sein, ohne dass ihre Inhalte auch für Googles KI-Produkte wie Gemini oder AI Overviews verwendet werden.

Google hat bewusst keine separate Opt-out-Option geschaffen. Verlage stehen vor einer "Alles-oder-Nichts"-Entscheidung: Entweder sie erlauben Google, ihre Inhalte sowohl für die traditionelle Suche als auch für KI-Anwendungen zu nutzen, oder sie müssen sich komplett aus dem Google Index entfernen. Das ist eine bewusste, strategische Entscheidung gewesen. U.a. Press Gazette:

Google considered allowing publishers to opt out of their data being used for AI grounding and still appear in search results but described it as a “hard red line”.

New documents disclosed in the remedies portion of an antitrust trial into Google’s search monopoly in the US reveals the tech giant preferred not to give publishers the option as it was “evolving into a space for monetisation”.

Das ist eine bewusste, strategische Ausnutzung der noch vorhandenen Marktmacht von Google im alten Suchmarkt. Jedes Unternehmen würde die dominante Position im etablierten Geschäftsfeld für Vorteile im Wachstumsfeld ausnutzen.

Now, was würde dagegen helfen? Richtig, mehr Wettbewerb. Es ist das Beste (naja, Zweitbeste nach einem Gewinner aus Europa oder ähnlichem), was Europa passieren konnte, dass Google, die Erfinder des Transformer-Ansatzes, nicht einfach von Anfang an KI dominiert haben.

Die Machtasymmetrie wird nicht kleiner.

Für uns Konsumenten ist ein Wettbewerb unter den Anbietern schlicht besser.

Das geht nicht nur uns kleinen Europäern so. Natürlich ist es für etwa Disney naheliegend, mit OpenAI einen 3-Jahres-Lizenz-Deal für Disney-Charaktere in der KI-Tiktok-App Sora abzuschließen und das Startup direkt mit einer Milliarde Dollar zu unterstützen. (Reuters, Tagesschau, OpenAI)

Sollte Disney mit Google kooperieren? Abgesehen davon, dass Google daran vielleicht weniger Interesse hätte als OpenAI: Es ist offensichtlich, dass der kleinere Herausforderer strategisch der bessere Partner ist als das Unternehmen, das die alte Websuche und mit YouTube(!) den Videostreamingmarkt dominiert.

Googles alte Websuche verliert kontinuierlich an Relevanz. Gleichzeitig sehen wir klare Konturen einer neuen dominanten Position.

Wir sehen das aktuell auch in der Geschwindigkeit der Entwicklung der Modelle. Gemini 3 hat GPT 5.2 und Claude Opus 4.5 sicher etwas nach vorn gezogen. Die drei großen amerikanischen Modellprovider werden sich auf absehbare Zeit ein Kopf-an-Kopf-Rennen liefern. Das heißt:

- kontinuierlich bessere Modelle

- kontinuierlich sinkende Inferenzkosten (per Token und, zunehmend, per Task)

Hinzu kommt natürlich noch, dass die chinesischen offenen (-ish) Modelle ebenfalls zum Wettbewerb beitragen.

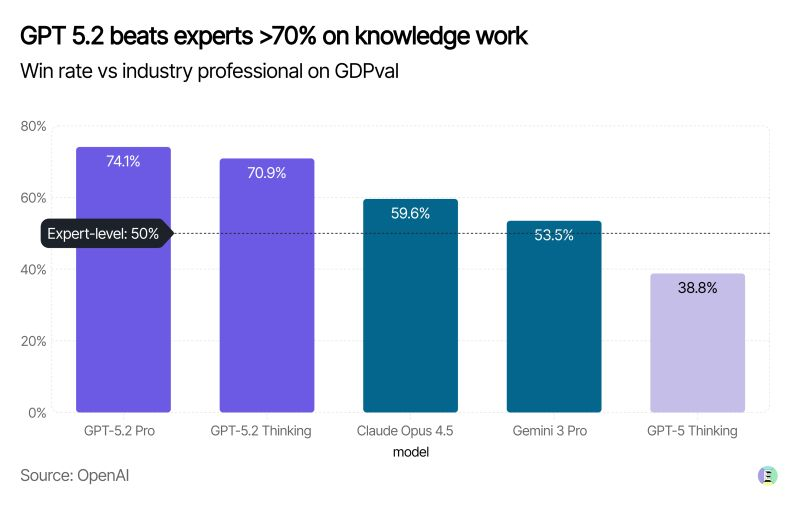

Die Qualität von GPT-5.2

GPT-5.2 schlägt in 70 Prozent der gestellten Aufgaben Experten. Das dürfte demnach bei den getesteten Aufgaben nun gegenüber Berufseinsteiger:innen bei 100 Prozent liegen..

Das sind signifikante Sprünge. Bei Modellen, deren Veröffentlichung nur Wochen oder Tage von einander entfernt lag.

(GDPval ist OpenAIs Benchmark, der KI an realen Arbeitsaufgaben aus 44 Berufen misst.. Statt akademischer Tests bewertet GDPval, ob Modelle praxisnahe Outputs liefern (juristische Schriftsätze, Tabellen, Präsentationen etc.) und lässt diese blind von Berufsexperten mit menschlichen Referenzen vergleichen. )

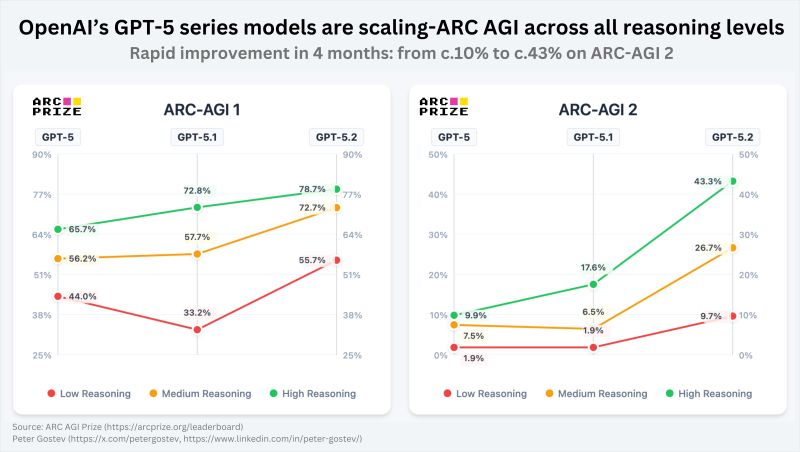

Ebenfalls relevant ist dieser Chart von Peter Gostev auf LinkedIn:

„Souveränität“ - Der Pfad zur selbstbestimmten Position

Oder: am besten vorgestern.

Ein letztes Wort zum aktuellen Lieblingstechthema hierzulande:

Bei Google sehen wir gut, wie man Herr des eigenen Schicksals wird. Indem man frühzeitig bewusst investiert und Weichen stellt. Die Cloud-Infrastruktur und die Entwicklung der TPUs sind seit über 10 Jahren ein Thema im Unternehmen.

Lesen Sie die ganze Geschichte

Melden Sie sich jetzt an, um die vollständige Geschichte zu lesen und Zugriff auf alle bezahlten Beiträge zu erhalten.

Abonnieren