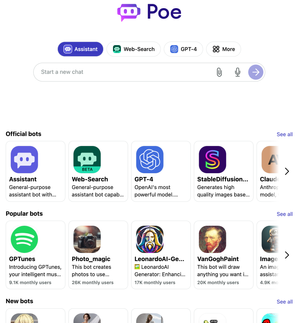

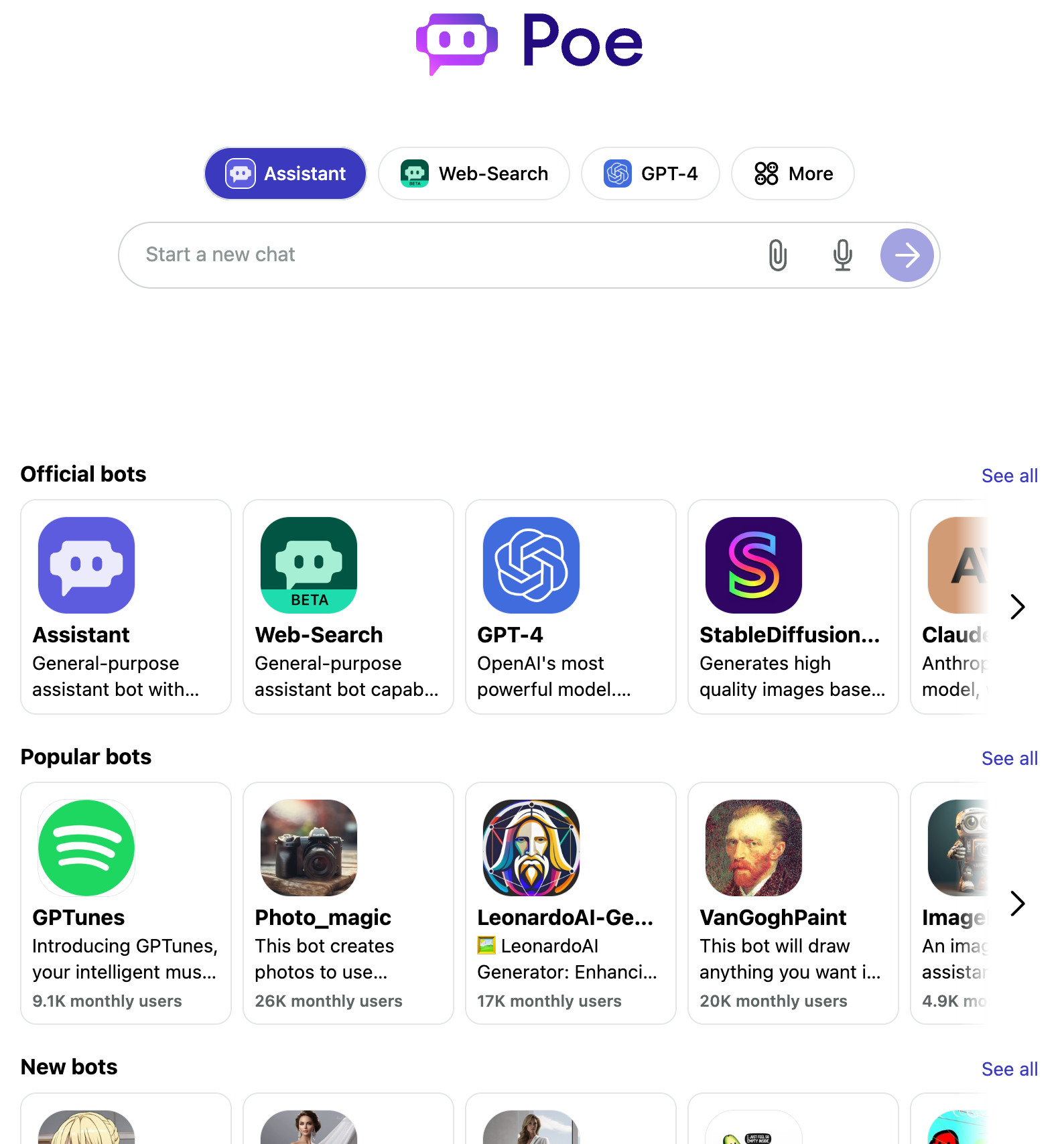

Poe, eine Tochter der Q&A-Plattform Quora, bietet in einer Oberfläche den Zugang zu allen relevanten Large Language Models (LLMs) und Text-zu-Bild-Generatoren an, die heute für Endnutzer:innnen verfügbar und per API einbindbar sind.

Warum es wichtig ist: Es ist noch alles andere als offensichtlich, wie sich die Arbeitsteilung zwischen den Anbietern im generativen KI/ML-Sektor entwickeln wird. Ein Aggregator, der Nutzer auf der einen Seite versammelt und mit den Modellen auf der anderen Seite zusammenbringt, kann theoretisch mächtig werden. Offen natürlich noch, ob das hier funktionieren wird. Es ist das etablierte Plattform-Playbook, das wir etwa vom Amazon-Marktplatz und anderen kennen, an dem sich Quora hier mit Poe versucht.

Poe, das kurz für 'Platform for Open Exploration' steht, hat diverse LLMs integriert:

- ChatGPT

- GPT-4

- Claude+ von Anthropic

- Quoras eigener Allgemeinwissens-Bot namens Sage

- StabilityXL-basierte Modelle

- viele mehr

Poe ist sicher der beste Weg aktuell, wenn man sich einen Überblick über die Fähigkeiten von endkonsumentengerichteten LLMs machen will.

Zu den spezialisierteren Angeboten zählen etwa:

- ein Bot, der auf das Schaffen von Liedtexten spezialisiert ist

- ein Prompt-Generator für MusicGen AudioCrafter (MusicGen auf HuggingFace)

- Spezialisierte Programmier-LLMs für Python, C++, HTML5, JavaScript, Unity, React Native, Roblox, Discord und mehr

Es sind neben den populären Modellen natürlich diese Special-Interest-Bots, die Poe versammelt bereits heute eine gewisse Distributionsmacht geben.

Aus der jüngsten Pressemitteilung:

StableDiffusionXL turns prompts into high quality, expressive images within seconds. You can build bots on top of this with simple prompts! There are hundreds of image generating bots already created.

Code Llama is a new model from Meta focused on coding.

API v2: For developers who want to build a chat-based AI product and bring it to a mass audience quickly and cost effectively, we have made some major API improvements. Developers’ bots on Poe now have the ability to call any other bot on Poe for free and use their output as input. Bots can also now return images and Poe clients will render them as first class image objects, as you saw above with the StableDiffusionXL bot. We built the StableDiffusionXL and Web Search bots ourselves using the same API that we’re making available to everyone else, and made a large number of additional small improvements in the process. To get started building a bot, visit developer.poe.com for more documentation.

Hier sehen wir erste, aggregierende Plattformdynamiken bzw. zunächst deren technische Grundlage. Mit der neuen API werden unter anderem Verbindungen von Modellen möglich:

Developers’ bots on Poe now have the ability to call any other bot on Poe for free and use their output as input.

Das heißt, Poe wird der Knotenpunkt, an dem Entwickler verschiedene Modelle miteinander verknüpfen können. Spezialisierte Modelle zu verknüpfen, ist ein spannender Weg, aus LLMs qualitativ bessere Resultate zu bekommen. (Modellkaskaden könnten eine der strukturellen Grenzen für OpenAI sein.)

Heute bereits noch relevanter ist Poes kommender B2B-Ansatz: Poe ist auf iOS, Android und als Desktop-App auf dem Mac verfügbar. Einen Enterprise-Plan wird es bald geben. (aktuell gibt es nur eine Warteliste)

Für smarte Unternehmen wird Enterprise-Poe ein sinnvoller Weg werden, die "geheimen Cyborgs" (Mitarbeitende, die LLMs heimlich benutzen), in die offiziellen & erlaubten Werkzeugkästen zu holen.

Tatsächlich liegt bei weitem das größte Potenzial für Poe in B2B.

Personalie: Quora-CEO Adam D'Angelo, seinerzeit Teil des Facebook-Gründungsteams, sitzt auch im Board von OpenAI.

Extrapolieren wir ein bisschen in die Zukunft, dann stellt sich die Frage, warum es einen Aggregator braucht. D'Angelos Antwort leuchtet ein: Es wird sehr viele Bots/Modelle geben.

"I think there's going to be this massive ecosystem similar to what the web is today," D'Angelo recently said. "I could imagine a world in which most companies have a bot that they provide to the public."

Die Frage ist natürlich, ob das dann alles in einem Chat-Interface aggregiert stattfinden wird. Das ist eher unwahrscheinlich, wie wir auch im jüngsten neunetzcast besprechen.

Aber wer einmal die Distribution hat, kann dann auch am Interface drehen und iterieren. (Generative KI geht als Querschnittstechnologie trotzdem über jede noch so große Plattform hinaus.)

Last not least, ein gewichtiger Grund, warum Aggregatoransätze zumindest aktuell noch eine Chance haben: Jeder LLM-Dienst kostet für die volle Funktionalität 20+/-€ pro Monat. Das sorgt dafür, dass selbst Poweruser selten mehr als einen dieser Dienste abonnieren, und nur in wirklich seltenen Ausnahmefällen mehr als zwei Dienste. Warum also nicht dahingehen, wo man die meisten Modelle hinter der Aboschranke verfügbar sind.

Ein Grund, der dagegen spricht: KI-Elemente werden in bestehende Tools integriert.

Im neuen neunetzcast 97 sprechen Markus Angermeier und ich darüber, wie wir 'KI' im Arbeitsalltag einsetzen: