Ich werde die Tage noch etwas über Sora und Vibes schreiben, möchte aber bereits diese neue Bezeichnung in die Runde werfen: User Prompted Content.

Marcel

Im Fokus dieser Ausgabe:

- ChatGPT: Das neue Monster

- Figure 03 und die Skaleneffekte für humanoide Robotik

- KI-Browser Dia und Comet frei verfügbar; eine kurze Einordnung der KI-Implementierung von Perplexity (it's not good)

- Das Ende der Hashtags

- und mehr

Zitat des Tages

I am hearing similar things in economics & the social sciences. Not autonomous work, but expert-directed AI is absolutely helping academics do novel research in significant ways. Especially Pro/High Thinking models.

Ethan Mollick in Reaktion auf Kevin Weil von OpenAI auf X:

✨ GPT-5 crossed a major threshold: over the last two months, we’ve heard repeated examples of scientists successfully directing GPT-5 to do novel research in math, physics, biology, CS, and more. If you have an example to share, please reply below! Prizes for the best ones 🧵👇

Als Beispiel siehe etwa Mathematik-Professor Terence Tao auf Mastodon.

Ich habe auch schon einige öffentliche Aussagen dieser Art gesehen, in der Regel in Bezug auf GPT-5 Pro, das bis diese Woche dem 200$-Plan vorenthalten war.

GPT-5 Pro ist jetzt via API verfügbar.

Thema der Woche: OpenAI DevDay

Im Grunde steht bereits alles in der heutigen Überschrift.

Nach GPTs und Plugins kommt jetzt die echte ChatGPT-Plattform. GPTs sind notwendig, aber zu wenig, Plugins sind gescheitert. (Ich glaube, ich habe seinerzeit gar nicht über Plugins geschrieben, mit der Ahnung, dass es nicht weit gehen wird.)

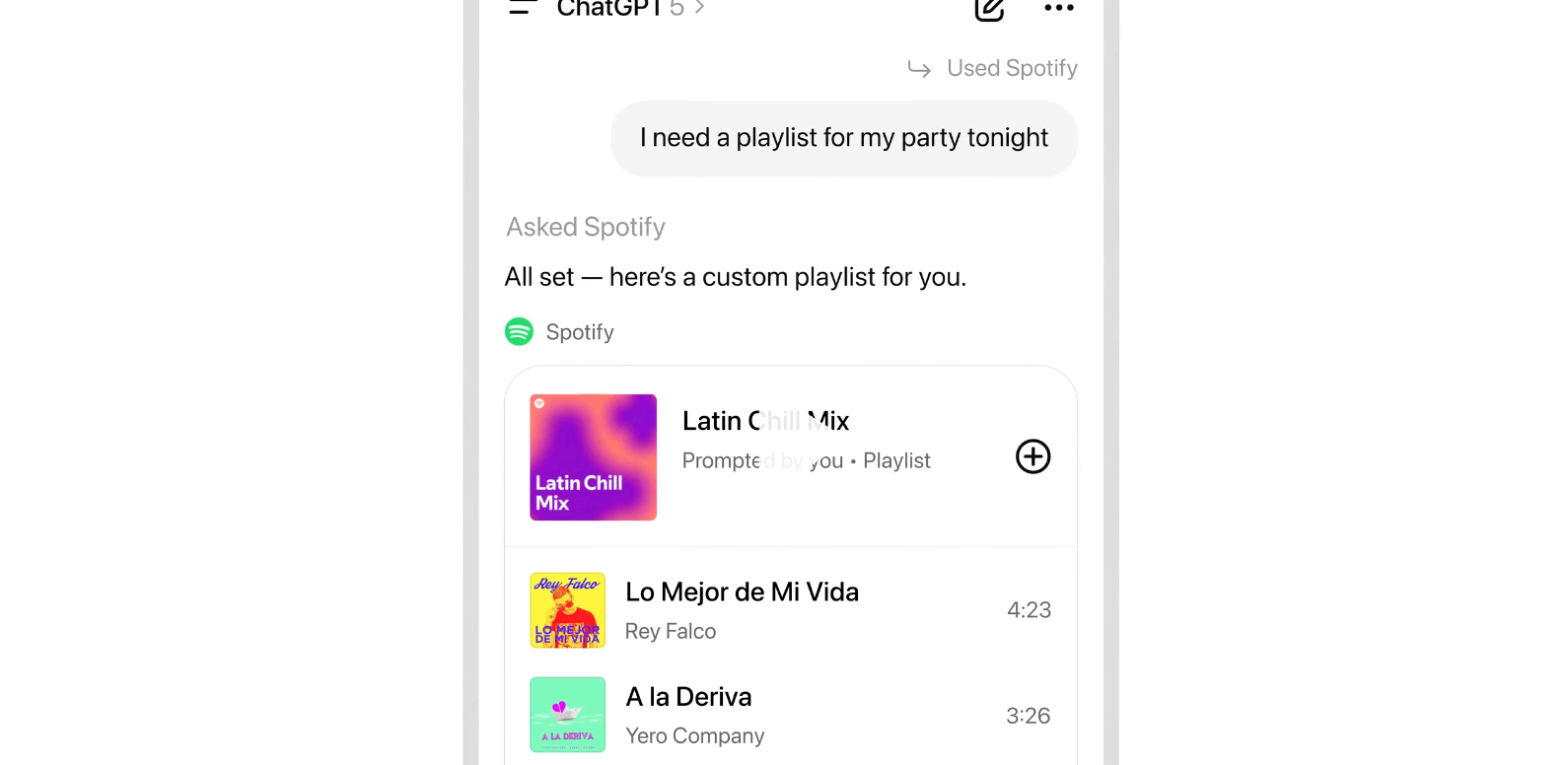

Aber jetzt werden Dienste direkt im Chat nutzbar.

In‑Chat‑Erlebnisse: Nutzer:innen können Apps per Name aufrufen und eingebettete, interaktive Inhalte sehen – z. B. Zillow‑Karten – ohne ChatGPT zu verlassen.

Entwickler‑Tools: OpenAI’s Apps SDK (Preview) und das Model Context Protocol ermöglichen es Apps, Daten, Werkzeuge und Workflows direkt in Chats einzubinden.

Verfügbarkeit: Die Funktion ist für Free‑, Go‑, Plus‑ und Pro‑Nutzer außerhalb der EU verfügbar. (Goddamnit)

Spotify‑Details als Bsp.: Spotifys Integration bietet maßgeschneiderte Empfehlungen, Stimmungs‑/Genre‑/Artist‑Playlists und Klick‑zum‑Anhören; Inhalte der Plattform werden nicht mit OpenAI zum Training geteilt.

Weitere Apps kommen: Künftige Integrationen sind u. a. von Uber, DoorDash, Instacart und AllTrails angekündigt.

Im Stratechery-Interview spricht Sam Altman explizit darüber, dass diese Integration besser für die Partner ist, man hätte auch Dinge machen können, die für die Nutzer:innen besser gewesen wären. Das ist unser kleiner Machiavelli, wie er im von der gesamten Branche gelesenen Newsletter sagt: Wir haben eine faire Plattform für euch gebaut.

Man muss das alles vor dem Kontext der Größe von ChatGPT sehen: Mittlerweile um die 800 Millionen wöchentliche Nutzer:innen. (Das ist sehr groß, riesig sogar für einen Dienst, der noch keine drei Jahre alt ist, aber dass sie keine DAUs nennen, ist... mindestens interessant.)

Diese Integration in die Chat-Oberfläche ist der Beginn der Plattform und des neuen von OpenAI gepushten Paradigmas.

ChatGPTs Distributionsgröße zieht die App/Service-Anbieter hinein.

Es reden bereits einige vom AI-Betriebssystem. Das ist nicht weit weg. Aber die Implikationen gehen weiter, als den meisten klar sein dürfte.

ChatGPT = Apple-Appstore + Google-Suche + WeChat-Superapp

OpenAI braucht Service-Integrationen für ihre kommenden KI-Gadgets.

Die Frage, wo die Apps herkommen sollen, hatte ich für KI-Gadgets allgemein aufgeworfen.

Die größte offene Frage bei all den KI-Gadgets wie Humane AI Pin oder Rabbit R1: Du kannst die App-Rankings einer beliebigen Kategorie nicht auf die Zahl 1 eindampfen. KI ist mächtig, aber ganze Branchen wegabstrahierende Chatbots werden aus offensichtlichen Gründen nicht das nächste große Interface sein. Was also stattdessen tun?

Denn was das Eindampfen bedeutet, kann man bei Humanes AI Pin sehen. Musik beim AI Pin heißt: Tidal. Das hat nicht die Nutzerin ausgesucht. Es ist das Ergebnis eines Hinterzimmerdeals zwischen Humane und Tidal.

OpenAI löst mit der Distributionsmacht von ChatGPT am Desktop und im Smartphone die Frage, wo die Apps für die kommenden Gadgets herkommen sollen.

Das löst nicht zu hundert Prozent die Frage nach dem Long Tail der Apps, lokale ÖPNV-Apps etwa. Es löst auch (noch) nicht die Frage nach der Discovery. Aber das ist alles lösbar.

Wir sehen hier ganz klar eine Vision entstehen: Hier wird ein neuer Tech-Riese gebaut, in dessen Zentrum KI steht. Alles neu gedacht mit KI im Zentrum.

Das ist dann, völlig erwartbar, etwas Neues.

Es vereint Apples Appstore und Googles Playstore (Apps!) mit der Google-Suche (es gab mal eine Zeit, da haben Leute geschrien, KI würde nicht Google ablösen haha!) und (und!) dem Superapp-Konzept von WeChat.

ChatGPT wird Discovery von (Web-)Themen + Basis für Gadgets + die erste Superapp im Westen!

Denn all die Apps werden über kurz oder lang auch in ChatGPT in iOS und Android verfügbar sein. Allgegenwärtig.

Das bringt mich zurück zu meiner allgemeinen Arbeitsthese: Als Sascha mich im Sommer in seinem Podcast fragte, ob es am Ende gar nicht um das Gadget ginge, sondern vielmehr um den KI-Browser als Zugangsweg, war meine Antwort: jein. Weder noch. Denn:

KI ist ein Cloud-Thema.

Zumindest was den Consumerbereich angeht.

KI in der Cloud ist das Zentrum, von dem aus alle Touchpoints bedient werden. Das zu Ende gedacht vereint bisher strikt getrennte Kategorien und schafft ein komplett neues Monster.

Ob sie das erreichen werden, hängt von vielen Faktoren ab. Die Chancen stehen gut.

Es gibt im Westen nur 2 Unternehmen, die dieses Spiel überhaupt spielen können, weil sie die Distribution und die technische Expertise haben: OpenAI und Google.

Über Sora reden wir ein anderes Mal. Aber man muss festhalten: Es ist bereits der zweite Hit von OpenAI nach ChatGPT. Something to ponder.

🦾 Robotik

Figure 03: Vertikal integrierter humanoider Roboter, auf dem Weg zur Massenfertigung

Figure stellt Figure 03 vor, einen humanoiden Roboter mit neuer Hardware und Software, der für Helix, den Einsatz im privaten Haushalt und Massenfertigung entwickelt wurde.

Ich empfehle allen, sich das Werbevideo anzuschauen:

Was Figure auszeichnet, ist die vertikale Integration: Die erste Iteration wurde mit einem OpenAI-Modell betrieben. Helix, das KI-Modell hinter den Robotern, ist eine Eigenentwicklung.

Neue Sensorik und Hände für Helix: Kameras liefern 2x Bildrate, 1/4 Latenz und 60% größeres Sichtfeld; Fingertip-Sensoren erkennen Kräfte ab 3 Grammfür feinmotorische Kontrolle.

Home-Optimierungen: 9% geringere Masse, weichere Textilien, waschbare Soft-Goods, 2 kW induktives Laden in den Füßen und verbesserte Audioleistung (Lautsprecher 2x größer, ~4x Leistung).

(Soft Goods = "Kleidung" für den Roboter)

Strategisch entscheidend ist, dass Figure 03 für Massenfertigung neu konstruiert wurde: Umstellung auf Druckguss/ Spritzguss, neue Zulieferkette, BotQ-Fabrik mit anfänglicher Kapazität bis zu 12.000 Robotern pro Jahr und Ziel 100.000 in vier Jahren.

KI-gestützte Robotik wird in den nächsten 20 Jahren zum größten Markt der Welt anwachsen. Innerhalb dieses Marktes wird der humanoide Formfaktor die bestimmende Unterkategorie werden, weil sie am flexibelsten einsetzbar ist. Aus dieser Flexibilität folgen enorme Skaleneffekte dank Massenproduktion.

Das scheint, siehe unten, in Europa noch kaum jemand zu erkennen.

Zumindest das US-Unternehmen Figure ist eine sehr eindeutige Wette auf diese These.

Sie werben auch für den Einsatz im Gewerbe: Schnellere Aktuatoren (2x), bessere Greifstabilität bei variierenden Objekten, drahtloses Laden und 10 Gbps mmWave-Dataoffload für Flotten-Lernen.

• Helix: Figure 03 features a completely redesigned sensory suite and hand system which is purpose-built to enable Helix - Figure's proprietary vision-language-action AI.

• The home: Figure 03 has several new features, including soft goods, wireless charging, improved audio system for voice reasoning, and battery safety advancements that make it safer and easier to use in a home environment.

• Mass manufacturing: Figure 03 was engineered from the ground-up for high-volume manufacturing. In order to scale, we established a new supply chain and entirely new process for manufacturing humanoid robots at BotQ.

• The world at scale:The lower manufacturing cost and the advancements made for Helix have significant benefits for commercial applications. Figure 03 introduces a fully redesigned sensory suite and hand system, purpose-built to bring Helix to life.

Softbank kauft ABB Robotics aus der Schweiz

Jetzt ist der Zeitpunkt, um in Robotik-Fähigkeiten zu investieren und notfalls Robotik-Übernahmen regulatorisch sehr genau zu betrachten.

OpenAI-Investor Softbank übernimmt also ABB Robotics.

Reuters:

SoftBank pushed into humanoid robotics a decade ago with its Pepper robot but later scaled back its ambitions.

Its recent investments in the sector include Berkshire Grey and AutoStore, and it also led a $40 billion funding round in ChatGPT-maker OpenAI and in March bought chip design company Ampere for $6.5 billion.

"SoftBank's next frontier is Physical AI," Son said in a statement.

The deal means ABB has abandoned its original decision to spin off and separately list the industrial automation business, which competes with Japan's Fanuc (6954.T), opens new tab and Yaskawa (6506.T), opens new tab, as well as Germany's Kuka in making factory robots.

"Germany's Kuka" ging 2016 an den chinesischen Konzern Midea.

🤖 KI

KI-Browser Dia und Comet frei verfügbar

Nachdem das Gericht in den USA entschied, dass Google den Browser Chrome behalten und alle Unternehmen von Apple bis Mozilla weiter bezahlen darf, landet Gemini langsam aber sicher in Chrome. Vertikale Integration incoming!

In der Zwischenzeit, den Atem im Nacken spürend, sind Dia und Comet jetzt frei verfügbar.

Dia hat jüngst eine Memorysuche eingeführt:

Just type @Search Memory into any Chat or Skill to call the right context from your past week of browsing,_ right when you need it._ Ask for that Notion doc your boss sent; summarize discussions with a close collaborator across Slack, Gmail, and Notion; or even build a Skill that helps you reflect on your last week and shape the next one.

Siehe dazu auch meine Analyse vom Sommer:

https://neunetz.com/briefing-267-ki-browser-sind-der-neue-plattformkampf/

Da Perplexity für maximales Wachstum und dafür verschenkte Pro-Pläne die eingebundenen Modelle maximal verblödet*, ist Dia, das mittlerweile zu Atlassian gehört, mein aktueller Kandidat für den vielversprechendsten KI-Browser.

*Es gibt Unterschiede wie Tag und Nacht bei Inferenzanbietern und noch stärker bei Startups, die gegen einen festen Jahres-/Monatsbetrag Zugang zu Modellen anbieten. Letztere können etwa das Kontextfenster gering halten, um möglichst wenige Input-Token zu bezahlen. Das merkt man bei Perplexity etwa daran, dass Follow-Up-Fragen oft ins Leere führen. Es gibt noch andere Hebel, die Kosten und Qualität senken können.

Planbare Lücke zwischen LLMs und SLMs

Das ist sehr wichtig. Frontier AI Performance Becomes Accessible on Consumer Hardware Within 9 Months:

Using a single top-of-the-line gaming GPU like NVIDIA’s RTX 5090 (under $2500), anyone can locally run models matching the absolute frontier of LLM performance from just nine months ago. This lag is consistent with our previous estimate of a 5 to 22 month gap for open-weight models of any size. We find that leading open models runnable on a single consumer GPU typically match the capabilities of frontier models after an average lag of 9 months. This relatively short and consistent lag means that the most advanced AI capabilities are becoming widely accessible for local development and experimentation in under a year.

Diese Lücke macht lokale KI-Integration planbar. Innerhalb eines Jahres bekommt man aktuell Modelle, die die Qualität heutiger Top-LLMs erreicht.

"AI first"

Sangeet Paul Choudary über AI First:

what it means to be architecturally-native to a new technology i.e. rebuilding your system around the logic of a new technology, not merely using it. Four shifts mark such system redesign:Atomic Unit Shift: Redefine the smallest unit of value. Figma (cloud-native) reimagined design work around the design element while Adobe was stuck to the logic of the file Roblox treats interactable experiences, not static games, as its atomic unit, allowing creators and players to co-create persistent worlds.Venetian trade shifted risk management from “chest of coins” to “ledger entry,” enabling credit, insurance, and scale.Stripe treats the API call as its atomic unit, turning payments from bespoke integrations into composable building blocks.Constraints as Design: Embrace limits as features.Containers’ fixed sizes standardized global logisticsTelegraph bandwidth created coded tickers/time-tables that synchronized rail networksTikTok embraced the constraint of ultra-short video length, which optimized its algorithmic discovery loop and drove a new logic for the feed.

Datenpunkte, wie KI das Web verändert

Spannende Daten.

A handful of major AI companies hire and control their own fleet of media, because companies realise that what can set them apart is access to original content (studio model of AIs). Everything that depends on traffic is threatened, including high quality journalism (see Azeem’s discussion with The Atlantic CEO Nicholas Thompson • Cloudflare controls ~20% of global web (based on 45M HTTP requests/s) • Cloudflare live -> 71.6% human; 28.4% bot (26th Sept) AI crawlers account for 80% of all bot traffic, with 18% YoY growth • Training traffic: 79-80% (up from 72%); Search traffic: 17% (down from 26%) • User actions: 3.2% (up from 2%) Crawl-to-referral imbalance: • Anthropic shows a 38,065:1, OpenAI 1,091:1, and Perplexity 195:1 • Agents generate up to 39,000+ requests per minute during peak usage • Reports of AI crawlers returning every 6 hours -> creating DDoS-like loads Anthropic’s Model Context Protocol launched in November 2024 • OpenAI adopted MCP in March 2025; Google DeepMind confirmed support in April 2025; Microsoft created an official C# SDK. • 4.3k MCP servers on github

Ich habe die Links zu den Quellen entfernt, weil es Tracking-Links von Substack waren. Links zu den Quellen findet man auf Exponential View.

📺 Medienwandel und vernetzte Öffentlichkeit

Das Ende der Hashtags

Why? Platforms don’t need them anymore. “As a type of metadata, [the hashtag] wasn’t controlled by a platform—it was created by the people, for the people,” Linguistics creator Adam Aleksic wrote in his most recent Substack essay, “Why platforms are killing the hashtag.” “By removing the hashtag, tech platforms are redistributing organizational power away from the users and toward themselves.” Big picture: Platforms have more recently focused on improving their search bar functionalities, rendering hashtags less impactful on overall performance.

Die Macht der Plattformen wird nicht nur den Wegfall der Hashtags sich verschieben, KI-Fähigkeiten machen die großen Plattformen immer undurchsichtiger.

Man vergleiche das hier direkt miteinander: Indem Hashtags verwendet werden, ordnen sich User selbst Gruppen zu. Auf LinkedIn ist der Wegfall von Hashtags wie "#B2B" egal. Aber was ist mit "#blacklivesmatter" oder "#metoo"?

Letztere Bottom-up-Gruppierungen werden ohne Hashtags unmöglich.

Ich gehe davon aus, dass wir ähnliche Verschiebungen an vielen Stellen dank KI bei den großen Plattformen sehen werden.

Eine Folge davon: Die Plattformen werden immer stärker auch vom Vibe her wie Entertainment-TV.

Das öffnet langfristig auch Chancen für Neues.

✴️ Mehr Wissenswertes

Bagel Labs’ “Paris” trains text‑to‑image via fully decentralized experts via Venturebeat:

Why it matters: Paris swaps giant synchronized clusters for eight independently trained diffusion experts and a small router, claiming comparable image quality with ~14× less data and ~16× less compute than a prior decentralized baseline. The appeal is obvious: Train on heterogeneous, scattered GPUs without InfiniBand; deploy with open weights. The catch: Routing and partitioning become your new dark arts.

Ich bin bei so etwas immer vorsichtig, aber das hier wäre ein sehr großer Deal.

Dwarkesh Patel, bester und wichtigster KI-Podcaster (Economist jüngst hilarious: "Did you listen to the new Dwarkesh?") über sein Interview mit Sutton.

Some Thoughts on the Sutton Interview:

LLMs aren’t capable of learning on-the-job, so we’ll need some new architecture to enable continual learning. And once we have it, we won’t need a special training phase — the agent will just learn on-the-fly, like all humans, and indeed, like all animals. This new paradigm will render our current approach with LLMs obsolete. AlphaGo (which was conditioned on human games) and AlphaZero (which was bootstrapped from scratch) were both superhuman Go players. AlphaZero was better. Will we (or the first AGIs) eventually come up with a general learning technique that requires no initialization of knowledge - that just bootstraps itself from the very start? And will it outperform the very best AIs that have been trained to that date? Probably yes. But does this mean that imitation learning must not play any role whatsoever in developing the first AGI, or even the first ASI? No. AlphaGo was still superhuman, despite being initially shepherded by human player data. The human data isn’t necessarily actively detrimental - at enough scale it just isn’t significantly helpful. Even if Sutton’s Platonic ideal doesn’t end up being the path to first AGI, he’s identifying genuine basic gaps which we don’t even notice because they are so pervasive in the current paradigm: lack of continual learning, abysmal sample efficiency, dependence on exhaustible human data. If the LLMs do get to AGI first, the successor systems they build will almost certainly be based on Richard’s vision. . As planes are to birds, supervised learning might be to human cultural learning.

Please let the robots have this one • The Argument Mag:

But even in San Francisco where Waymos are a reality, I still run into a lot of Waymo haters. Sometimes they hate the cars for taking jobs from Uber and Lyft drivers. (Though remember how a couple of years ago everyone wanted to ban Uber and Lyft?) Sometimes they hate the cars out of vague anti-corporate sentiment. But often, what they really hate isn’t Waymo at all.

Rausschmeißer der Woche

Ethan Ding: In 100 Years, People Will Marvel at the Idea That...:

in 100 years, people will marvel at the idea that business logic in systems of record ever had a moat, or produced margins [like railroads] we are in a closing window of time where demand for software [logic] has allowed tech companies to make 80% margins for ~2 decades no tmrethan ding 📊 @TheEthanDingsystems of records will not have a moat in 10 years the writing is on the wall for those paying attention everything is compute

~